Estudiantes de la Universidad de Washington crearon unos guantes para traducir el lenguaje de signos al verbal para facilitar la comunicación entre personas con discapacidad auditiva y oyentes.

Navid Azodi y Thomas Pryor, los inventores, explicaron que estos guantes están equipados con sensores avanzados que detectan los movimientos y posiciones de las manos del usuario.

Los sensores de los guantes recopilan datos sobre la orientación y posición de las manos, así como los movimientos específicos realizados al gesticular en lenguaje de signos.

Estos datos se envían de manera inalámbrica a una computadora que utiliza algoritmos de aprendizaje automático para traducir los gestos a texto o tiempo real. El sistema está diseñado para reconocer una amplia variedad de gestos y combinaciones, lo que permite una traducción precisa y fluida del lenguaje de señas.

El potencial de SignAloud para integrarse en diversas situaciones cotidianas es uno de sus aspectos más destacados. En el ámbito educativo, un estudiante sordo podría utilizar estos guantes para participar más activamente en clases y discusiones, traduciendo sus señas en tiempo real para que el resto de los alumnos y profesores puedan comprenderlos.

De igual manera, en el entorno laboral, los empleados con dificultades auditivas podrían comunicarse más eficazmente con sus compañeros y supervisores, eliminando barreras y promoviendo una mayor inclusión.

El desarrollo de SignAloud ha sido ampliamente reconocido por su enfoque innovador y su impacto. En 2016, sus creadores recibieron el prestigioso Premio Lemelson-MIT para estudiantes, otorgado a jóvenes inventores que demuestran una gran capacidad para crear tecnologías revolucionarias.

Este reconocimiento destaca la ingeniosidad detrás de los guantes y la relevancia de la tecnología en la mejora de la calidad de vida de las personas sordas.

A pesar de sus capacidades, SignAloud enfrenta varios desafíos. Uno de los principales retos es desarrollar un sistema que pueda reconocer y traducir correctamente la diversidad de signos y dialectos del lenguaje de señas.

Cada región y comunidad tiene variaciones en su uso del lenguaje de señas, lo que requiere que el sistema sea adaptable y capaz de aprender continuamente. Además, la precisión y rapidez de la traducción son cruciales para asegurar una comunicación efectiva y natural.

Otro desafío es la aceptación y adopción de esta tecnología por parte de la comunidad sorda. Aunque los guantes ofrecen una herramienta poderosa para la traducción del lenguaje de señas, es fundamental que su diseño y funcionalidad respondan a las necesidades y preferencias de los usuarios.

La colaboración con personas sordas y expertos en el lenguaje de señas durante el proceso de desarrollo es esencial para garantizar que el producto final sea verdaderamente útil y aceptado por quienes más lo necesitan.

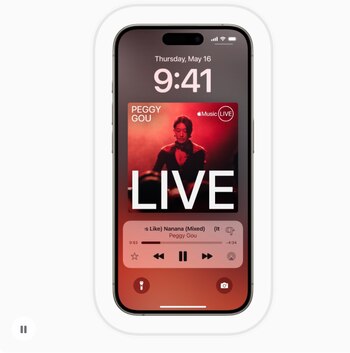

Nuevas funciones de accesibilidad de iOS

Apple ha anunciado nuevas características de accesibilidad que incluyen ‘Seguimiento de Ojos’, ‘Music Haptics’ y ‘Vocal Shortcuts’, destinadas a mejorar la experiencia de usuarios con discapacidades.

‘Seguimiento de Ojos’ permite a los usuarios controlar su iPad mediante el movimiento de sus ojos. Esta tecnología avanzada utiliza sensores para seguir la mirada del usuario, facilitando la navegación y la interacción sin necesidad de utilizar las manos. Es una herramienta pensada para personas con movilidad reducida.

‘Music Haptics’ es una función diseñada para personas con discapacidades auditivas. Utilizando vibraciones hápticas, su iPhone puede convertir la música en señales táctiles que se sincronizan con el ritmo y los matices del sonido.

Finalmente, ‘Vocal Shortcuts’ simplifica el uso del dispositivo mediante comandos de voz personalizados. Los usuarios pueden crear atajos vocales para ejecutar acciones específicas en sus dispositivos Apple, mejorando la eficiencia y facilitando el acceso a funciones clave.

“La inteligencia artificial tiene el potencial de mejorar el reconocimiento de voz para millones de personas con habla atípica, por lo que nos llena de emoción que Apple lleve estas nuevas funcionalidades de accesibilidad a sus consumidores”, comentó Mark Hasegawa-Johnson, investigador de la Universidad de Illinois Urbana-Champaign.

Últimas Noticias

Cómo formatear el celular para que dejarlo con la configuración de fábrica

Restaurar el teléfono a estado de fábrica elimina datos confidenciales y malware, facilitando una experiencia más ágil y segura antes de vender, transferir o reutilizar el dispositivo en cualquier situación cotidiana

Evita ser espiado: la configuración clave para proteger las conversaciones en su móvil

El control sobre el acceso de las aplicaciones al micrófono es esencial para evitar escuchas, anuncios personalizados y riesgos de espionaje digital en la vida cotidiana

Cómo usar Google Nest para crear un sistema profesional de alarma en casa contra los ladrones

Este dispositivo permite personalizar acciones y horarios para reforzar la seguridad cuando no hay nadie en casa

El truco perfecto de un extrabajador de Google para no usar seguido el celular en el trabajo

El método se basa en principios de psicología del comportamiento y modifica el entorno digital para reducir el uso impulsivo

Adiós al aumento de la tarifa de energía en el verano: conoce la temperatura ideal del aire acondicionado

La mayoría de electrodomésticos modernos cuentan con funciones inteligentes que permiten ahorrar dinero y mantener el interior del hogar confortable y fresco