Google anunció Project Gameface, una herramienta que permite controlar el cursor de una computadora mediante movimientos de cabeza y gestos faciales. Esta innovación fue conocida el año pasado, pero durante el evento I/O 2024 abrieron dichas funcionalidades a Android.

En un principio era dirigido especialmente a personas con discapacidades, este “ratón” manos libres emplea la cámara del dispositivo para rastrear expresiones faciales y movimientos de cabeza, facilitando así el acceso a la tecnología.

Ahora, Google quiso pasar todas estas funciones a dispositivos móviles Android, adaptándolo además en controlar aplicaciones de este sistema operativo por medio de más de 60 gestos faciales.

Cuál es la apuesta de Google con esta función

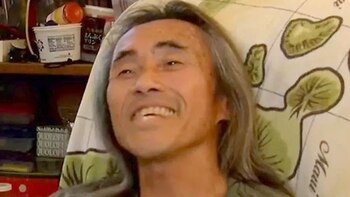

Project Gameface se inspiró en la historia del streamer de videojuegos Lance Carr, quien padece distrofia muscular, y fue desarrollado en colaboración con él, difundió Google.

Este proyecto hace que el entretenimiento sea más accesible, permitiendo acciones como levantar las cejas para hacer clic y arrastrar o abrir la boca para mover el cursor. La compañía ha dicho que varias empresas la han comenzado a usar en su software inclusivo.

Google ha explicado en su blog que esta idea inicial de mover el cursor con la cabeza ha sido adaptada para celulares Android. Utilizando la cámara frontal del móvil, la tecnología analiza las expresiones faciales y movimientos de la cabeza, traduciendo estos gestos en un control personalizado y práctico.

Esto significa que los usuarios pueden adaptar su experiencia ajustando las expresiones faciales, el tamaño de los gestos y la velocidad del cursor, entre otras opciones.

En qué se diferencia la versión PC con la móvil

En la versión para Windows, Project Gameface permitía replicar acciones comunes de clic. No obstante, la versión para Android incluye una gama más amplia de capacidades.

Los usuarios ahora pueden realizar acciones móviles soportadas globalmente, como “Inicio”, “Atrás”, “Notificaciones” y “Todas las Aplicaciones”. Además, se introdujo una mejora significativa permitiendo el arrastre en tiempo real, que facilita una interacción más versátil.

Del mismo modo, para integrar Project Gameface en Android, Google ha empleado el servicio de accesibilidad del sistema operativo para crear un nuevo cursor.

También ha utilizado la API de detección de puntos de referencia faciales de su servicio MediaPipe, permitiendo que el cursor se mueva de acuerdo con los gestos faciales. Esta API reconoce 52 gestos, como levantar las cejas y abrir la boca, que pueden ser utilizados para mapear y controlar una amplia gama de funciones.

Qué acciones puedes realizar con sus gestos faciales

En un primer momento Google enfocó esta herramienta para los videojuegos, pero en este momento, las aplicaciones para Android que incluyan Project Gameface permitirán a los usuarios escribir en plataformas de mensajería instantánea controlando el cursor con movimientos de la cabeza.

Google ha reiterado que el código fuente de Project Gameface está disponible en Github,que cualquier desarrollador pueda implementar esta tecnología en sus aplicaciones y mejorar la accesibilidad de los dispositivos Android.

Google quiere brindar mayor accesibilidad a los usuarios

Según la compañía, el diseño y desarrollo de Project Gameface para Android se basó en estos principios clave:

- Ampliar las posibilidades de uso de dispositivos móviles a personas con discapacidad.

- Crear una solución rentable y que se prolongue con el tiempo.

- Usar la API de Detección de Marcadores Faciales de MediaPipe para mapear y controlar una amplia gama de funciones.

Además, se estima que los desarrolladores programen aplicaciones en las que los usuarios configuren su experiencia y personalicen expresiones faciales y gestos, ajustando el tamaño de los gestos y la velocidad del cursor.

Estas son algunas novedades que pasaron en el marco del evento anual para desarrolladores Google I/O, con otras relacionadas con la potenciación de la Inteligencia Artificial, Gemini.

Últimas Noticias

Si el PIN de tu tarjeta coincide con esta lista de números, cuidado: tu dinero está en peligro

Los delincuentes aprovechan que los usuarios suelen repetir contraseñas de otras plataformas bancarias, redes sociales o fechas especiales para robar dinero y datos

Cuáles son los nombres del año 2025 para tu hijos, segun la IA

Los papás tienen la posibilidad de pedirle a la IA recomendaciones según sus preferencias para hallar el nombre perfecto para su hijo

Cuida tu dinero: siete tipos de aplicaciones que podrían robar tus datos sin que lo notes

Los usuarios tienen la responsabilidad de verificar los permisos que le otorgan a cada app

Hace 18 años Steve Jobs cambió el mundo: así fue la presentación del primer iPhone

El entonces director ejecutivo de Apple consideraba que los teléfonos móviles no debían tener teclado ni botones

Google elimina 200 páginas de streaming ilegal: un paso clave contra la piratería

La acción, impulsada por sanciones de la Unión Europea, busca combatir la distribución no autorizada de contenido y proteger a los usuarios de riesgos cibernéticos