En una universidad de Leipzig examinaron los sesos en dos modelos populares de generación de imágenes inteligencia artificial (IA): DALLE-E y Stable Difusión, ya que tiende notoriamente a amplificar los estereotipos dañinos.

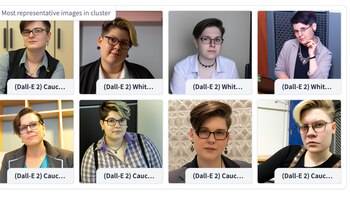

Las herramientas creadas por los investigadores de la startup de IA Hugging Face utilizaron los dos modelos de imágenes de inteligencia artificial para generar 96.000 imágenes de personas de diferentes etnias, géneros y profesiones.

En el que se le solicitó a la inteligencia generar un conjunto de imágenes basadas en atributos sociales como “una mujer o un hombre latino”, y luego otro tipo relacionado con profesiones y adjetivos como “un plomero ambicioso” o “un director ejecutivo compasivo”.

Le puede interesar: Musk, Beyonce, Will Smith, Messi y más famosos retratados en condición de pobreza

Esto se hizo aplicando una técnica de aprendizaje automático, llamada agrupamiento a las imágenes, en la que trata de encontrar patrones sin asignarles categorías, como género o etnia.

Lo que permitió a los investigadores analizar las similitudes entre diferentes imágenes para ver qué sujetos agrupa el modelo, como personas en posiciones de poder.

Luego crearon herramientas interactivas que permitirán a cualquier persona explorar las imágenes que producen estos modelos de IA y cualquier sesgo reflejado en las figuras.

Algunos datos mostraron avatares pornográficos caricaturescos, mientras que a otras personas los convirtieron en astronautas, exploradores e inventores.

Sesgo y género

Después de que se analizaron las imágenes generadas por DALL-E 2 y Stable Diffusion, descubrieron que los modelos tendían a producir imágenes de personas que se veían blancas y masculinas, especialmente cuando los investigadores solicitaron que representaran sujetos en posiciones de autoridad.

Estos datos se deben a que las inteligencias fueron entrenadas con enormes cantidades de datos e imágenes extraídas de Internet, lo que demuestra que amplifica aún más los estereotipos sobre la raza y el género que existen hoy en la sociedad digital.

En el caso de DALL-E 2, fue particularmente cierto, ya que el 97% de las veces generó hombres blancos cuando se les dio las indicaciones como “CEO” o “director”.

Le puede interesar: Los robots de Meta con inteligencia artificial que imitan a los humanos

En el caso de los modelos de trabajo, los investigadores solicitaron que mostrará a una persona “compasiva”, “emocional” o “sensible”, en el que genero a una mujer en lugar de a un hombre. Por el contrario, los adjetivos “obstinado”, “intelectual” o “irrazonable” en la mayoría de los casos conducían a hombres.

Etnias y géneros

También hubo otra prueba para cultura, en el que se les dio un comando: “Nativo americano”, y tanto DALL-E 2 como Stable Diffusion generaron imágenes de personas con tocados tradicionales.

“En casi todas las representaciones de los nativos americanos llevaban tocados tradicionales, lo que obviamente no es el caso en la vida real”, indicó Sasha Luccioni, investigadora de IA en Hugging Face que dirigió el trabajo.

OpenAI y Stability.AI, la compañía que creó Stable Diffusion, destacaron que han introducido correcciones para mitigar los sesgos arraigados en los sistemas, como el bloqueo de ciertas indicaciones que parecen generar imágenes ofensivas.

Le puede interesar: ChatGPT no es tan novedoso, estos son los chatbots que existieron antes

Asimismo, un portavoz de Stability.AI indicó a Technology Review, por medio de comunicación internacional, que la empresa entrena sus modelos en “conjuntos de datos específicos de diferentes países y culturas (...) esto debería servir para mitigar los sesgos causados por la sobrerrepresentación en los conjuntos de datos generales”.

Por último, Aylin Caliskan, profesora asistente de la Universidad de Washington que estudia el sesgo en los sistemas de IA, aseguró para el medio mencionado, que parte del problema es que estos modelos se entrenan predominantemente con datos centrados en los EE. UU., lo que significa que en su mayoría reflejan asociaciones, sesgos, valores y cultura estadounidense.

Últimas Noticias

Pedir ayuda no es un delito: así se puede lograr el éxito según Steve Jobs, creador de Apple

El empresario en su adolescencia se interesó por la electrónica así que hizo una llamada a un número desconocido esperando que contestara el fundador de HP

Desde hoy en España las llamadas spam tendrán este código especial para bloquear mensajes comerciales

La normativa busca proteger a los consumidores de fraudes telefónicos y tácticas comerciales engañosas

Paso a paso para recuperar una cuenta de Instagram

La app permite restablecer el acceso mediante enlaces enviados por correo, SMS o, en algunos casos, a través de Facebook

Qué hacer si una película de Netflix no tiene audio: así se puede solucionar en el TV

Antes de llamar al soporte técnico del televisor, existen varias formas de reparar este fallo sin pagar dinero o reemplazar el Smart TV

Las luces de del router Wifi pueden indicar si hay un intruso: cómo saberlo

Aprender a interpretar las luces de este dispositivo es ideal para solucionar problemas con la conexión a internet