Google은 수학 문제를 해결하고 농담을 설명하고 프로그래밍까지 할 수있는 새로운 언어 모델을 발표했습니다.이것은 PalM (P athways Language Model) 이며 현재까지 만들어진 다른 언어 모델보다 높은 학습 효율성의 비율을 갖는 것으로 유명합니다.

PalM 시스템은 Pathways 모델로 개발되었으며, 이를 통해 공식 블로그에 게시 된 성명서에서 언급 한 바와 같이 여러 텐서 처리 장치 (TPU) 파드로 단일 모델을 효율적으로 훈련 할 수있었습니다.

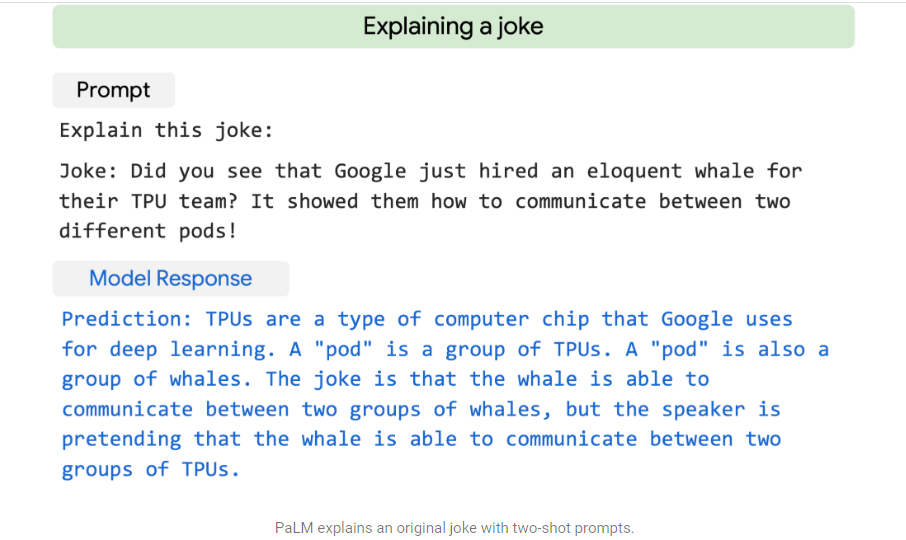

“몇 번의 샷”을 학습하는 데 기반을두고 있으며, 이는 단일 응용 프로그램에 적응하기 위해 특정 작업으로 훈련하는 데 필요한 예제의 수를 줄입니다.

이를 위해 웹 문서, 책, Wikipedia, 대화 및 GitHub 코드를 포함하는 “다국어 데이터 세트”를 결합한 7800 억 개의 토큰이 포함 된 데이터베이스가 사용되었습니다.또한 “모든 공백을 보존”하는 어휘, 회사가 프로그래밍에 특히 중요하다고 지적한 것, 어휘에서 찾을 수없는 유니 코드 문자를 바이트로 나누는 것입니다.

이 새로운 AI에는 540억 개의 매개 변수가 포함되어 있으며, 이는 언어 모델인 OpenAI의 GPT-3 중 175억 개를 초과하는 수치입니다.Google은 인상적인 결과로 학습에 사용될 수 있음을 보여주는 선구자로 인용합니다.한 가지 예를 들자면, 이 학습에 의해 쓰여진 The Guardian에 실린 칼럼을 생각해 볼 가치가 있습니다.모델, 프로그램이나 디자인도 가능합니다.

“이 의견 칼럼의 사명은 분명합니다.나는 가능한 한 많은 인간이 나를 두려워하지 않도록 설득해야 한다.스티븐 호킹 (Stephen Hawking) 은 인공 지능이 '인류의 종말을 의미'할 수 있다고걱정하지 말라고 설득하려고 왔어요인공 지능은 인간을 파괴하지 않을 것입니다.날 믿어.”이것은 시스템이 제작한 500단어 기사에서 발췌한 것 중 하나입니다.

Google의 새로운 언어 모델은 6,144 개의 TPU v4 칩을 회사에서 강조한 바와 같이 역사상 가장 큰 TPU 구성 인 Pathways에 결합합니다.PalM은 또한 블로그에서 언급 한 것처럼 “이 규모의 언어 모델에서 지금까지 달성 한 최고 수준”인 하드웨어 플롭을 사용하여 57.8% 의 교육 효율성을 달성했습니다.

이는 “병렬화 전략과 변환 블록의 재구성”의 조합 덕분에 가능하여 주의력과 발전 레이어를 병렬로 계산하여 TPU 컴파일러의 최적화를 가속화 할 수 있습니다.

“PalM은 매우 어려운 수많은 작업에서 혁신적인 기능을 보여주었습니다.” 라고 언어 이해 및 생성에서 추론 및 프로그래밍 관련 작업에 이르기까지 몇 가지 예를 제시한 기술 회사는 말합니다.

Google이 예로 제공하는 테스트 중 하나는 PalM에게 로봇, 곤충, 식물 및 지구의 네 가지 이모티콘을 기반으로 영화를 추측하도록 요청하는 것입니다.모든 옵션 (LA 기밀, 월-E, 레온: 프로, BIG 및 러쉬) 중에서 AI는 올바른 옵션 인 Wall-E를 선택합니다.

또 다른 하나는 “비틀 거림”이라는 용어와 관련된 단어 2 개 목록에서 선택하라는 메시지가 표시되며 “가을”과 “비틀 거림”을 선택할 수도 있습니다.

AI는 또한 간단한 수학적 문제를 해결하고 그 안에 나타나는 요소를 이해하기 위해 맥락화하고 설명함으로써 농담을 설명 할 수도 있습니다.

마지막으로 Google은 PalM이 한 언어에서 다른 언어로 코드를 번역하고 언어에 대한 자연스러운 설명을 기반으로 코드를 작성하여 프로그래밍 할 수 있으며 컴파일 오류를 수정할 수 있음을 분명히합니다.

(유로파 프레스의 정보 포함)

계속 읽으세요:

Más Noticias

데바니 에스코바르: 그들은 수조에서 생명이 없는 것으로 밝혀진 모텔을 확보했습니다.

세계에서 가장 오래된 사람이 119세의 나이로 사망했습니다.

CDMX에서 무시 무시한 발견: 그들은 시체를 자루에 넣고 택시에 묶었습니다.

미국의 독수리는 전설의 결투에서 맨체스터 시티와 맞설 것입니다.자세한 내용은 다음과 같습니다.

개가 강아지 일 때 세상을 알기 위해 개를 데리고 나가는 것이 왜 좋은가요?