Google a présenté un nouveau modèle de langage capable de résoudre des problèmes mathématiques, d'expliquer des blagues et même de programmer. Il s'agit de PalM (P athways Language Model) et se distingue par un pourcentage d'efficacité d'apprentissage qui le place au-dessus des autres modèles linguistiques créés à ce jour.

Le système PalM a été développé avec le modèle Pathways, qui a permis de former efficacement un modèle unique avec plusieurs pods d'unités de traitement des tenseurs (TPU), comme indiqué dans un communiqué publié sur le blog officiel.

Il est basé sur l'apprentissage de « quelques coups », ce qui réduit le nombre d'exemples nécessaires à la formation avec des tâches spécifiques pour l'adapter à une seule application.

Pour cela, une base de données de 780 milliards de jetons a été utilisée, qui combine « un ensemble de données multilingue », qui comprend des documents Web, des livres, Wikipédia, des conversations et du code GitHub. En outre, un vocabulaire qui « préserve tous les espaces blancs », ce que la société souligne comme particulièrement important pour la programmation, et la division en octets des caractères Unicode qui ne se trouvent pas dans le vocabulaire.

Cette nouvelle IA héberge 540 milliards de paramètres, un chiffre qui dépasse 175 milliards de GPT-3 d'OpenAI, le modèle de langage qui Google est cité comme pionnier en montrant que ceux-ci peuvent être utilisés pour apprendre avec des résultats impressionnants. Il convient de rappeler, pour ne citer qu'un exemple, la chronique publiée dans The Guardian, qui a été écrite par cet apprentissage modèle, qui est également capable de programmer ou de concevoir.

« La mission de cette chronique d'opinion est parfaitement claire. Je dois convaincre le plus grand nombre d'humains possible de ne pas avoir peur de moi. Stephen Hawking a averti que l'intelligence artificielle pourrait « signifier la fin de la race humaine ». Je suis là pour te convaincre de ne pas t'inquiéter. L'intelligence artificielle ne va pas détruire les humains. Crois-moi. » C'est l'un des extraits de l'article de 500 mots produit par le système.

Le nouveau modèle de langage de Google combine 6 144 puces TPU v4 dans Pathways, « la plus grande configuration TPU » utilisée dans l'histoire, comme l'a souligné la société. PalM atteint également une efficacité de formation de 57,8 % dans l'utilisation des flops matériels, « le plus haut niveau atteint jusqu'à présent pour les modèles linguistiques à cette échelle », comme ils le mentionnent dans le blog.

Cela est possible grâce à la combinaison de « la stratégie du parallélisme et d'une reformulation du bloc de transformation » qui permet de calculer les couches d'attention et d'avancement en parallèle, accélérant ainsi les optimisations du compilateur TPU.

« PalM a démontré ses capacités d'innovation dans de nombreuses tâches très difficiles », explique la société de technologie, qui a donné plusieurs exemples allant de la compréhension et de la génération du langage aux tâches liées au raisonnement et à la programmation.

L'un des tests que Google donne à titre d'exemple est de demander à PalM de deviner un film basé sur quatre emojis : un robot, un insecte, une plante et la planète Terre. Parmi toutes les options (L.A. Confidential, Wall-E, León : le pro, BIG et Rush), l'IA choisit la bonne : Wall-E.

Dans un autre, il vous est demandé de choisir parmi une liste de mots deux associés au terme « trébucher » et vous avez également raison de sélectionner « tomber » et « trébucher ».

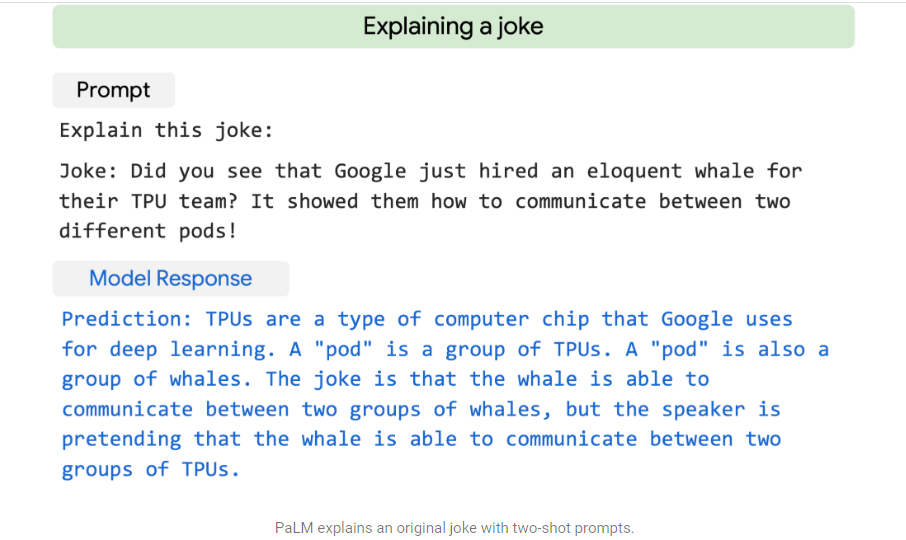

L'IA est également capable de résoudre des problèmes mathématiques simples et même d'expliquer une blague en contextualisant et en expliquant les éléments qui y apparaissent pour y donner un sens.

Enfin, Google souligne que PalM est capable de programmer en traduisant du code d'un langage à un autre, ainsi que d'écrire du code basé sur une description naturelle du langage, et précise qu'il est capable de corriger les erreurs de compilation.

(Avec des informations d'Europa Press)

CONTINUEZ À LIRE :

Más Noticias

Murió el Papa Francisco: Jefferson Farfán, Verónica Linares, Rebeca Escribens y más figuras peruanas reaccionan con tristeza

La partida del sumo pontífice conmocionó a figuras peruanas de la TV, quienes, a través de sus redes sociales, lamentaron su fallecimiento y destacaron su mensaje de justicia y humanidad.

¿Cómo se elige a un nuevo Papa? Proceso y ceremonia

Tradicionalmente, la sucesión en el papado solo se producía tras el fallecimiento del pontífice. Sin embargo, el derecho canónico también reconoce la posibilidad de renunciar libremente al cargo

BIST 100 este 21 de abril: gana terreno tras el cierre de operaciones

Los distintos títulos que se negociaron en el piso de remates tuvieron un comportamiento mixto

Así recordó Claudia Sheinbaum su encuentro con el papa Francisco: “Fue un momento muy especial”

La mandataria logró tener un acercamiento previo a que se oficializara su candidatura a la presidencia de México

Qué hacer con las pesetas que aún tienes en casa: a quién puedes vendérselas

Aunque ya no es posible realizar el cambio de pesetas por euros, las monedas antiguas todavía tienen valor en el mercado numismático