Los “robots asesinos” ya dejaron de ser una invención de la ciencia-ficción. Se convirtieron en una realidad. Los drones autónomos de grado militar pueden volar por sí mismos a un lugar específico, elegir sus propios objetivos y matar sin la ayuda de un operador humano a distancia. Y ya se probaron en el campo de batalla. De acuerdo a una investigación de Naciones Unidas, fue en Libia en marzo de 2020. Allí se usó un dron cargado con el sistema de armas autónomas letales (LAWS) durante los combates entre las fuerzas del Gobierno de Acuerdo Nacional y las fuerzas alineadas con el general Khalifa Haftar. Esto encendió las alarmas en todo el mundo. No hay ninguna norma internacional que limite este tipo de armamento. Es por eso que representantes de 125 países están reunidos en Suiza para intentar incorporar esta legislación en la Convención de Ginebra de 1949 que trata de poner límites a las atrocidades que se cometen en las guerras.

Este año se supo de un proyecto secreto de drones letales en el Reino Unido y de un programa de desarrollo de armas de inteligencia artificial desarrollado por un grupo de adolescentes en China. Google ayudó al Pentágono con un proyecto de imágenes de Inteligencia Artificial con drones. El año pasado, el ruso Vladimir Putin dijo que la nación que lidere la Inteligencia Artificial “será la que gobierne el mundo”. La cuestión en este momento no es si las armas autónomas están en camino, sino qué forma debería adoptar la regulación internacional para controlarlas, si es que la hay. En la ONU están trabajando en el tema desde hace ocho años sin mayor éxito.

“Animo a la Conferencia de Revisión (de la Convención de Ginebra) a acordar un plan ambicioso para el futuro que establezca restricciones al uso de ciertos tipos de armas autónomas”, dijo el Secretario General de la ONU, Antonio Guterres, al inaugurar el encuentro de cinco días en la ciudad suiza. Algunos países participantes, como Austria, piden la prohibición total de las LAWS, mientras que otros, como Estados Unidos, se muestran más reticentes. El argumento de estos últimos es que “estas armas podrían ser más ventajosas que otras, son más precisas que los humanos a la hora de alcanzar objetivos”. Amnistía Internacional y grupos de la sociedad civil están exigiendo que se negocie cuanto antes un tratado internacional. Rusia, directamente se opone a cualquier pacto. “El ritmo de la tecnología está empezando a superar el ritmo de las conversaciones diplomáticas”, dijo Clare Conboy, de la ONG Stop Killer Robots en uno de los foros de la conferencia. “Esta es una oportunidad histórica para que los Estados tomen medidas para salvaguardar a la humanidad contra la autonomía en el uso de la fuerza”.

“Todo el mundo está de acuerdo en que, en el corpus del derecho internacional existente, no hay nada que prohíba específicamente las armas autónomas”, explicó Paul Scharre, director del Programa de Tecnología y Seguridad Nacional del Centro para una Nueva Seguridad Americana a la NPR, la radio estatal estadounidense. “No hay tratados independientes, como los existen para muchas otras armas. Además, existe la creencia generalizado de gente que no sabe sobre el tema de que las leyes de guerra existentes tampoco sirven de mucho”.

Scharre dice que las opiniones sobre la inteligencia artificial y la guerra pueden dividirse en tres campos. En un extremo está la Campaña para Detener a los Robots Asesinos, una coalición de más de 85 organizaciones no gubernamentales que aboga por la prohibición preventiva de las armas totalmente autónomas. Su pensamiento está respaldado por un puñado de países diferentes, como Austria, Brasil y el Vaticano. Algunas empresas de robótica, como Clearpath Robotics, Hanson Robotics y DeepMind, filial de Alphabet, también han apoyado por separado la prohibición. En el otro extremo se encuentran Rusia y Estados Unidos, que en septiembre se movilizaron para bloquear las conversaciones de la ONU para avanzar en la prohibición preventiva. En medio de estos dos polos se encuentran países como Francia y Alemania, que apoyan una resolución políticamente vinculante; una declaración sobre las armas autónomas, pero no necesariamente un tratado legalmente vinculante.

Lo cierto es que hoy a un robot autónomo en el campo de batalla se le aplicarían las mismas convenciones sobre la guerra que a cualquier soldado humano. “Tomemos por ejemplo un médico autónomo”, explica el profesor Peter Roberts, director de ciencias militares del grupo de reflexión de defensa británico Royal United Services Institute (RUSI) en un “paper” presentado en la asamblea de Ginebra. “Digamos que tiene la capacidad de salir, encontrar a un soldado que está en problemas y tratarlo. Ese robot tiene exactamente los mismos derechos bajo las Convenciones de Ginebra que tendría un humano. No puede ser objetivo de una potencia extranjera. No puede ser molestado en el transcurso de su trabajo, a menos que esté cargado con armas y haya disparado. Conserva las mismas protecciones que tendrían los humanos”.

El concepto de autonomía también es menos claro de lo que parece a primera vista. ¿Dónde empiezan y terminan los límites del control humano?

¿Estos robots estarían bajo las tres leyes de la robótica de Isaac Asimov?:

1) “Un robot no hará daño a un ser humano ni, por inacción, permitirá que un ser humano sufra daño.

2) Un robot debe cumplir las órdenes dadas por los seres humanos, a excepción de aquellas que entren en conflicto con la primera ley.

3) Un robot debe proteger su propia existencia en la medida en que esta protección no entre en conflicto con la primera o con la segunda ley.

Una forma de poner ciertos límites sería la creación de un tratado específico como el que regula el uso de las Municiones en Racimo (CCM), que impide el almacenamiento y uso de bombas de racimo contra civiles, o el Tratado de Ottawa que controla el uso de minas antipersonales. “Pero en ambos casos había un clamor generalizado que ahora no existe. Se había registrado un gran número de personas mutiladas por las minas terrestres y las bombas de racimo. Hubo un conjunto muy fuerte de instancias para presionar a la comunidad internacional”, explica Scharre.

Cualquier discusión al respecto, primero tendría que encontrar una definición exacta de qué es un “robot asesino” y cuáles serían los posibles controles de su accionar. ¿Estarían incorporados en su software o dependería sólo de la misión que un humano le ordene y, en ese caso, el límite lo pondría esa persona? Desde ya, habría que verlo desde un punto de vista de un cambio profundo en los conceptos de la guerra que se están produciendo desde hace años. Más que un arma que hay que prohibir, es una fuerza que está provocando un cambio más profundo en el carácter de la guerra. No es un arma, es una revolución científico-tecnológica inédita -o apenas comparable con la Revolución Industrial- en la historia de la Humanidad.

En tanto, comienza a haber una cierta resistencia de la sociedad civil al uso de los robot militares autónomos. Google ya anunció que no renovará un contrato con el ejército estadounidense. Se trata del programa para utilizar la Inteligencia Artificial en el análisis automático de imágenes de drones, denominado Proyecto Maven. La decisión de la empresa se produjo tras una fuerte reacción interna, con decenas de renuncias y una petición firmada por miles de empleados. El Maven analiza enormes magnitudes de imágenes grabadas por los drones estadounidenses que sería casi imposible de realizar para el ojo humano. La inteligencia artificial determinará entonces si se visualiza algún peligro y si habría que “neutralizarlo”. Lo preocupante es que estas máquinas tomen la decisión de disparar en forma autónoma. “Estos programas también ilustran una maravillosa ironía”, escribió Peter Singer, estratega y miembro senior del think tank New America. “Nuestro uso cada vez mayor de la tecnología ha producido cantidades de datos enormemente mayores a velocidades que son difíciles de seguir para los humanos. Así que, a su vez, buscamos nuevas tecnologías para seguir el ritmo”.

En los pasillos de la conferencia de Ginebra, dicen que “sería relativamente fácil apoyar la prohibición de los robots soldados al estilo Terminator, pero mucho más difícil es acordar dónde trazar las líneas en torno a los distintos niveles de autonomía que se están introduciendo en los sistemas militares. Los límites del control humano son nebulosos, pero hay que precisarlos”. Los delegados tienen otros tres días para intentar aproximarse a una visión más humana del uso bélico de la inteligencia artificial. Las tres reglas que Asimov imaginó en 1942 podría el marco perfecto para una nueva convención.

Últimas Noticias

Giorgia Meloni defendió a Elon Musk de las críticas: “¿El problema es que es influyente y rico o que no es de izquierda?“

La primera ministra italiana dijo que el magnate ejerce su derecho a la libertad de expresión. En cambio, acusó a poderosos de la izquierda de injerencia política, entre ellos el multimillonario George Soros

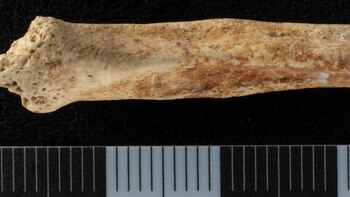

Un grupo de arqueólogos halló en un pozo en Londres un hueso de pene de perro de la época romana

Este descubrimiento, pintado con ocre rojo, planteó nuevas preguntas sobre los rituales y creencias de las antiguas comunidades en Gran Bretaña

Caos en Chad: 19 muertos en un sangriento asalto al palacio presidencial

Un grupo armado con cuchillos atacó sorpresivamente la sede de gobierno en Yamena, resultando en la muerte de 18 asaltantes y un soldado. El incidente ocurrió horas después de la visita del canciller chino y en medio de tensiones post-electorales

Rumanía detectó el primer caso de HMPV en una mujer que no viajó al extranjero

La paciente de 67 años presentó los primero síntomas el 26 de diciembre, ahora se encuentra hospitalizada, aislada y en estado estable

Un paseo familiar termina en hallazgo arqueológico único: un amuleto de 2.500 años

Un niño de 11 años encontró una figura de cerámica en el río Besor, en Israel. El descubrimiento podría ser clave para entender tradiciones y creencias antiguas