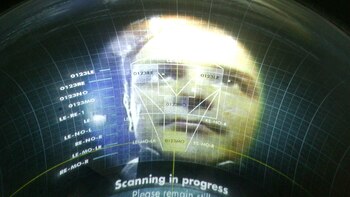

¿Qué dicen los rasgos faciales sobre una persona? Prejuicios aparte, más bien poco. De allí la polémica en torno a una nueva máquina que, dicen, es capaz de determinar la orientación sexual de alguien con tan solo analizar una foto.

De acuerdo con un estudio realizado por la Universidad de Stanford, la inteligencia artificial en cuestión es capaz de distinguir si un hombre es homosexual en el 91% de los casos, mientras que alcanza un 83% de efectividad cuando analiza a una mujer. Ambos porcentajes superan a la observación del ojo humano, que según los números de la investigación, llegan al 61 y 54% de aciertos respectivamente.

El estudio, ya aprobado y próximo a publicarse en Journal of Personality and Social Psychology, indagó en una cuantiosa base de datos. Los investigadores capacitaron a la máquina con 35.326 caras de 14.776 personas que tomaron de perfiles públicos de una página web de citas.

Ni bien se conocieron los resultados preliminares, se desató una ola de repudio encabezada por distintas organizaciones que defienden los derechos LGTBI. Denunciaron una invasión a la intimidad ya que, por caso, puede traer serios problemas para aquellos que viven en países donde la homosexualidad es un delito.

"Imagínate por un momento las consecuencias si esta investigación se utilizase para apoyar a un régimen que quiere identificar y perseguir a personas homosexuales", sostuvo Ashland Johnson, directora de educación e investigación pública de la Campaña de Derechos Humanos, en un comunicado. "Stanford debería alejarse de esa ciencia basura. Dejar de dar su nombre y credibilidad a una investigación que contiene errores y crea una situación de inseguridad para millones de personas", agregó.

Los dos autores del estudio, Michal Kosinski y Yilun Wang, de inmediato se defendieron con una nota aclaratoria. Reconocieron los límites de sus alcances y aseguraron que el objetivo de su investigación no era otro que alertar a la población de los usos peligrosos que puede tener una IA si no se la regula como es debido.

"Una de mis obligaciones como científico es que si sé algo que pueda proteger a la gente de ser una víctima de estos riesgos, debería publicarlo", explicó a The Guardian Kosinski quien, al recibir múltiples amenazas, publicó un mensaje en su cuenta de Twitter en el que pide mesura antes de despedazarlo. "Por favor, lea un resumen de nuestras conclusiones antes de contratar al pelotón de fusilamiento", escribió.

A su vez, los autores sugirieron que los resultados van de la mano con la teoría que marca que la orientación sexual se define durante el nacimiento. Según la hipótesis, los fetos masculinos expuestos a menos andrógenos serán gays, mientras que los fetos femeninos que reciben más andrógenos serán lesbianas.

Para determinar las preferencias sexuales de las personas, el software se centró en la nariz, los ojos, las cejas, las mejillas, el corte de pelo y la barba en el caso de los hombres. Por el lado de las mujeres, se focalizó en la nariz, los ángulos de la boca, el pelo y la línea del cuello.

LEA MÁS:

Últimas Noticias

Iquitos: la predicción del clima para este 18 de diciembre

¿Cuál es la temperatura promedio en Mazatlán?

Nuevo correo electrónico: ‘Xmail’ sería la propuesta de Elon Musk para el mundo

La nutricionista Boticaria García revela cuántas tazas de café podemos beber al día: “Siempre y cuando no las tomemos de golpe...”

Un décimo de la Lotería de Navidad vendido en un colegio tiene un error de impresión: el número que aparece puede que no sea el real